- ASIC

- バッテリー マネージメントIC

- クロックとタイミングソリューション

- ESDおよびサージ保護デバイス

- 自動車用イーサネット

- 評価ボード

- 高信頼性(HiRel)

- アイソレーター

- メモリ

- マイクロコントローラー

- パワー

- RF

- セキュリティ ソリューションおよびスマートカードソリューション

- センサー技術

- 小信号トランジスタおよびダイオード

- トランシーバー

- ユニバーサル シリアル バス(USB)

- ワイヤレス接続

- Search Tools

- Technology

- Packages

- Product Information

- ご注文

- 概要

- 自動車用イーサネットブリッジ

- 車載ネットワーク向け自動車用イーサネットPHY

- 車載ネットワーク向け自動車用イーサネット スイッチ

- 概要

- 組込みフラッシュIPソリューション

- フラッシュプラスRAM MCPソリューション

- F-RAM (強誘電体RAM)

- NORフラッシュ

- nvSRAM (不揮発性 SRAM)

- PSRAM (擬似スタティック RAM)

- 耐放射線・高信頼性メモリ

- SRAM (スタティック RAM)

- ウェーハおよびダイメモリソリューション

- 概要

- 32ビットFM Arm® Cortex® マイクロコントローラー

- 32ビットAURIX™ TriCore™マイクロコントローラー

- 32ビットPSOC™ Arm® Cortex® マイクロコントローラー

- 32ビット TRAVEO™ T2G Arm® Cortex® マイクロコントローラー

- 32ビットXMC™産業用マイクロコントローラー Arm® Cortex®-M

- レガシー マイクロコントローラー

- モーター制御SoC/SiP

- センシングコントローラー

- 概要

- AC-DC電力変換

- 従来型の車載パワートレインIC

- クラスD オーディオアンプIC

- 非接触パワー&センシングIC

- DC/DCコンバーター

- ダイオードとサイリスタ (Si/SiC)

- 窒化ガリウム(GaN)

- ゲートドライバIC

- IGBT – 絶縁ゲート型バイポーラトランジスタ

- インテリジェント パワーモジュール (IPM)

- LEDドライバIC

- モータードライバ

- パワーMOSFET

- パワーモジュール

- 電源IC

- 保護および監視IC

- シリコンカーバイド (SiC)

- スマート パワー スイッチ

- ソリッドステートリレー (SSR)

- ワイヤレス充電IC

- 概要

- アンテナクロススイッチ

- アンテナチューナー

- バイアスと制御

- カプラ

- ドライバアンプ

- 高信頼性ディスクリート

- ローノイズアンプ (LNA)

- 高周波ダイオード

- RFスイッチ

- RFトランジスタ

- ワイヤレス制御向けレシーバー

- 概要

- Calypso®製品

- CIPURSE™ 製品

- 非接触メモリ

- OPTIGA™の組込みセキュリティ ソリューションの詳細

- SECORA™セキュリティソリューション

- セキュリ ティコントローラー

- スマートカードモジュール

- 政府ID向けスマートソリューション

- 概要

- ToF 3D イメージセンサー

- Current sensors

- ガスセンサー

- 誘導型位置センサー

- MEMSマイクロフォン

- 圧力センサー

- レーダーセンサー

- 磁気位置センサー

- 磁気速度センサー

- 概要

- USB 2.0 ペリフェラル コントローラー

- USB 3.2 ペリフェラル コントローラー

- USB ハブ コントローラー

- USB PD高電圧マイクロコントローラー

- USB-C AC-DC および DC-DC 充電ソリューション

- USB-C充電ポートコントローラー

- USB-Cパワーデリバリー コントローラー

- 概要

- AIROC™ オートモーティブワイヤレス

- AIROC™ Bluetooth®およびマルチプロトコル

- AIROC™ コネクトテッドMCU

- AIROC™ Wi-Fi + Bluetooth®コンボ

- 概要

- FM0+ 32ビット Arm® Cortex®-M0+ マイクロコントローラー (MCU)

-

FM3 32ビットArm® Cortex-M3®マイクロコントローラー (MCU) ファミリー

- 概要

- FM3 CY9AFx1xKシリーズ Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM3 CY9AFx1xL/M/N シリーズ Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM3 CY9AFx2xK/L シリーズ Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM3 CY9AFx3xK/L シリーズ 超低リーク Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM3 CY9AFx4xL/M/N シリーズ 低消費電力 Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM3 CY9AFx5xM/N/Rシリーズ 低消費電力 Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM3 CY9AFxAxL/M/N シリーズ 超低リーク Arm® Cortex®-M3 マイクロコントローラー (MCU)

- FM3 CY9BFx1xN/R 高性能シリーズ Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM3 CY9BFx1xS/T 高性能シリーズ Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM3 CY9BFx2xJシリーズ Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM3 CY9BFx2xK/L/Mシリーズ Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM3 CY9BFx2xS/Tシリーズ Arm® Cortex®-M3マイクロコントローラー (MCU)

- FM4 32ビットArm® Cortex-M4®マイクロコントローラー (MCU) ファミリー

- 概要

-

32 ビット TriCore™ AURIX™ – TC2x

- 概要

- AURIX™ ファミリー – TC21xL

- AURIX™ファミリー – TC21xSC (ワイヤレス充電)

- AURIX™ ファミリー – TC22xL

- AURIX™ ファミリー – TC23xL

- AURIX™ ファミリー – TC23xLA (ADAS)

- AURIX™ ファミリー – TC23xLX

- AURIX™ ファミリー – TC264DA (ADAS)

- AURIX™ ファミリー – TC26xD

- AURIX™ ファミリー – TC27xT

- AURIX™ ファミリー – TC297TA (ADAS)

- AURIX™ ファミリー – TC29xT

- AURIX™ファミリー – TC29xTT (ADAS)

- AURIX™ ファミリー – TC29xTX

- AURIX™ TC2xx (エミュレーションデバイス)

-

32 ビット TriCore™ AURIX™ – TC3x

- 概要

- AURIX™ ファミリー TC32xLP

- AURIX™ ファミリー – TC33xDA

- AURIX™ ファミリー - TC33xLP

- AURIX™ ファミリー – TC35xTA (ADAS)

- AURIX™ ファミリー – TC36xDP

- AURIX™ ファミリー – TC37xTP

- AURIX™ ファミリー – TC37xTX

- AURIX™ ファミリー – TC38xQP

- AURIX™ ファミリー – TC39xXA (ADAS)

- AURIX™ ファミリー – TC39xXX

- AURIX™ ファミリー – TC3Ex

- AURIX™ TC37xTE (エミュレーションデバイス)

- AURIX™ TC39xXE (エミュレーションデバイス)

- 32 ビット TriCore™ AURIX™ - TC4x

- 概要

- PSOC™ 4 Arm® Cortex® -M0/M0+

- PSOC™ 4 HV Arm® Cortex® -M0+

- PSOC™ 5 LP Arm® Cortex® -M3

- PSOC™ 6 Arm® Cortex®-M4 / M0+

- PSOC™ Multitouch Touchscreen Controller

- PSOC™ Control C3 Arm® Cortex®-M33

- 自動車用PSOC™ 4 Arm® Cortex®-M0/M0+

- PSOC™ Edge Arm® Cortex® M55/M33

- 概要

- ボディ用32ビットTRAVEO™T2G Arm® Cortex®

- クラスター用の 32 ビット TRAVEO™ T2G Arm® Cortex®

- 概要

- 32ビットXMC1000産業用マイクロコントローラー Arm® Cortex®-M0

- Cortex-M4® Arm® 32ビットXMC4000産業用マイクロコントローラー

- XMC5000産業用マイクロコントローラーArm® Cortex® -M4F

- 32ビットXMC7000産業用マイクロコントローラー Arm® Cortex®-M7®

- 概要

- 整流ブリッジおよびACスイッチ

- CoolSiC™ ショットキーダイオード

- ダイオードベアダイ

- Si ダイオード

- サイリスタ/ダイオード パワーモジュール

- サイリスタソフトスタータモジュール

- サイリスタ / ダイオードディスク

- 概要

- BLDCモータードライバ

- BDCモータードライバ

- ステッピングモーターおよびサーボモーター ドライバ

- MCU搭載モータードライバ

- MOSFETを使用したブリッジドライバ

- Gate driver ICs

- 概要

- 車載用MOSFET

- デュアルMOSFET

- MOSFET(Si&SiC)モジュール

- NチャネルデプレッションモードMOSFET

- NチャネルMOSFET

- PチャネルMOSFET

- CoolSiC™ MOSFET

- 小信号/小電力MOSFET

- 概要

- 車載用トランシーバー

- OPTIREG™リニア電圧レギュレーター (LDO)

- OPTIREG™ PMIC

- OPTIREG™ スイッチャー(車載用)

- OPTIREG™ システム ベーシス チップ (SBC)

- 概要

- eFuse

-

ハイサイドスイッチ

- 概要

- Classic PROFET™ 12V |車載用スマート ハイサイドスイッチ

- Classic PROFET™ 24 V |車載用スマート ハイサイドスイッチ

- Power PROFET™ + 12/24/48 V |車載用スマート ハイサイドスイッチ

- PROFET™+ 12V |車載用スマート ハイサイドスイッチ

- PROFET™+ 24V |車載用スマート ハイサイドスイッチ

- PROFET™+ 48 V |車載用スマート ハイサイドスイッチ

- PROFET™+2 12 V |車載用スマート ハイサイドスイッチ

- PROFET™ | 産業用スマート ハイサイドスイッチ

- PROFET™ Wire Guard 12V | Automotive eFuse

- ローサイドスイッチ

- マルチチャネルSPIスイッチおよびコントローラー

- 概要

- EZ-USB™ CX3 MIPI CSI-2 to USB 5 Gbps カメラ コントローラー

- EZ-USB™ FX10 & FX5N USB 10Gbpsペリフェラルコントローラ

- EZ-USB™ FX20 USB 20 Gbpsペリフェラルコントローラー

- EZ-USB™ FX3 USB 5 Gbps ペリフェラル コントローラー

- EZ-USB™ FX3S USB 5 Gbps ペリフェラル コントローラー (ストレージ インターフェース付き)

- EZ-USB™ FX5 USB 5 Gbpsペリフェラルコントローラー

- EZ-USB™ SD3 USB 5 Gbps ストレージコントローラー

- EZ-USB™ SX3: FIFOインターフェースの USB 5 Gbps ペリフェラル コントローラー

- 概要

- EZ-PD™ CCG3 USB Type-Cポート コントローラーPD

- EZ-PD™ CCG3PA USB-C および PD

- EZ-PD™ CCG3PA-NFET USB-C PD コントローラー

- EZ-PD™ CCG7x シングルポート USB-Cパワーデリバリーおよび DC-DC コントローラー

- EZ-PD™ PAG1: 第 1 世代電源アダプター

- EZ-PD™ PAG2: 第 2 世代電源アダプター

- EZ-PD™ PAG2-PD USB-C PD コントローラー

- 概要

- EZ-PD™ ACG1F 1ポートUSB-Cコントローラー

- EZ-PD™ CCG2 USB Type-Cポート コントローラー

- EZ-PD™ CCG3PA車載用USB-Cおよびパワーデリバリーコントローラー

- EZ-PD™ CCG4 2 ポートUSB-CおよびPD

- EZ-PD™ CCG5デュアルポートおよび CCG5C シングルポート USB-C PDコントローラー

- EZ-PD™ CCG6 1ポート USB-C & PDコントローラー

- EZ-PD™ CCG6_CFP および EZ-PD™ CCG8_CFPデュアルシングルポート USB-C PD

- EZ-PD™ CCG6DFデュアルポートおよびCCG6SFシングルポートUSB-C PDコントローラー

- EZ-PD™ CCG7D車載用デュアルポートUSB-C PD + DC-DCコントローラー

- DC-DCコントローラーを搭載した、EZ-PD™ CCG7S車載用シングルポートUSB-C PDソリューション

- EZ-PD™ CCG7SAF車載用シングルポートUSB-C PD + DC-DCコントローラー + FET

- EZ-PD™ CCG8デュアル シングル ポートUSB-C PD

- EZ-PD™ CMG1 USB-C EMCAコントローラー

- 拡張パワーレンジ (EPR) 搭載EZ-PD™ CMG2 USB-C EMCA

- 最新情報

- 航空宇宙および防衛

- 自動車

- 民生用電子機器

- ヘルスケアとライフスタイル

- 家電製品

- 産業用アプリケーション

- 情報通信技術

- 再生可能エネルギー

- ロボティックス

- セキュリティソリューション

- スマートホームとスマートビルディング

- ソリューション

- 概要

- 電源アダプターと充電器

- スマートテレビ向けの完全なシステムソリューション

- モバイルデバイスとスマートフォンソリューション

- マルチコプターとドローン

- 電動工具

- ホームエンターテインメント アプリケーション向けの半導体ソリューション

- スマート会議システム

- 概要

- アダプターおよび充電器

- 資産管理の追跡

- バッテリーの形成とテスト

- 電動フォークリフト

- バッテリー蓄電 (BESS)

- EV充電

- 高電圧ソリッドステート配電

- 産業用オートメーション

- 産業用モータードライブおよび制御

- インダストリー4.0向けの産業用ロボットシステムソリューション

- LED 照明システムの設計

- 小型電気自動車ソリューション

- 電動工具

- 送配電

- トラクション

- 無停電電源装置 (UPS)

- 概要

- データセンターおよびAIデータセンターソリューション

- エッジサーバーソリューション

- 通信インフラ

- Machine Learning Edge AI

- 概要

- デバイス認証とブランド保護

- モノのインターネット (IoT) 向けの組み込みセキュリティ

- eSIM アプリケーション

- 公的身分証明書

- モバイルセキュリティ

- 決済ソリューション

- アクセス管理および発券ソリューション

- 概要

- 家庭用ロボット

- 空調システム (HVAC)

- ホームオートメーションとビルオートメーション

- PCアクセサリ

- ホームエンターテインメント アプリケーション向けの半導体ソリューション

- 概要

- 車載用補助システム

- 車載ゲートウェイ

- 車載用パワー分配システム

- ボディコントロールモジュール(BCM)

- コンフォート&コンビニエンス エレクトロニクス

- ゾーンDC-DCコンバーター 48 V~12 V

- ゾーンコントロールユニット

- 概要

- アクティブサスペンションコントロール

- エアバッグシステム

- 車載用ブレーキング ソリューション

- 車載用ステアリング ソリューション

- シャーシ ドメイン制御

- リバーシブル シートベルト プリテンショナー

- 最新情報

- デジタル ドキュメンテーション

- 評価ボード

- ファインダー & セレクション ツール

- プラットフォーム

- サービス

- インフィニオン オンライン パワー シミュレーション プラットフォーム

- ソフトウェア

- ツール

- パートナー

- インフィニオン フォー メーカーズ

- ユニバーシティ アライアンス プログラム

- 概要

- AIROC™ ソフトウェアとツール

- AURIX™のツールとソフトウェア

- 自動車ソフトウェア開発用のDRIVECORE

- iMOTION™ ツールとソフトウェア

- インフィニオンのスマートパワースイッチおよびゲートドライバ ツールスイート

- MOTIX™ ソフトウェア&ツール

- OPTIGA™ ツールとソフトウェア

- PSOC™ ソフトウェアとツール

- TRAVEO™ ソフトウェアとツール

- XENSIV™ツールおよびソフトウェア

- XMC™ ツールとソフトウェア

- 概要

- AURIX™認証

- AURIX™開発ツール

- AURIX™組込みソフトウェア

- AURIX™マイクロコントローラーキット

- 概要

- CAPSENSE™コントローラー コンフィギュレーション ツール EZ-Click

- DC-DC統合POL電圧レギュレーター設定ツール – PowIRCenter

- EZ-USB™ SX3コンフィギュレーション ユーティリティ

- FM+ コンフィギュレーション ツール

- FMx設定ツール

- トランシーバーICコンフィギュレーション ツール

- USB EZ-PD™コンフィギュレーション ユーティリティ

- USB EZ-PD™コンフィギュレーション ユーティリティ

- USB EZ-USB™ HX3C Blaster Plusコンフィギュレーション ユーティリティ

- USB UARTコンフィギュレーション ユーティリティ

- XENSIV™タイヤ空気圧センサーのプログラミング

- 概要

- EZ-PD™ CCGx Dock ソフトウェア開発キット

- FMx Softune IDE

- ModusToolbox™ ソフトウェア

- PSOC™ ソフトウェア

- レーダー開発キット

- 錆

- USBコントローラーSDK

- ワイヤレス接続 Bluetooth メッシュヘルパー アプリケーション

- XMC™ DAVE™ソフトウェア

- 概要

- AIROC™ Bluetooth® Connect Appアーカイブ

- Cypress™ Programmerのアーカイブ

- EZ-PD™ CCGx 電力ソフトウェア開発キットのアーカイブ

- ModusToolbox™ ソフトウェアのアーカイブ

- PSOC™ Creatorのアーカイブ

- PSOC™ Designerのアーカイブ

- PSOC™ Programmerのアーカイブ

- USB EZ-PD™コンフィギュレーション ユーティリティ アーカイブ

- USB EZ-PD™ホストSDKのアーカイブ

- USB EZ-USB™ FX3のアーカイブ

- EZ-USB™ HX3PD コンフィギュレーション ユーティリティ

- WICED™ Smart SDKのアーカイブ

- WICED™ Studioのアーカイブ

- 最新情報

- サポート

- トレーニング

- 開発者コミュニティ

- News

ビジネス&財務プレス

2026/02/19

ビジネス&財務プレス

2026/02/19

ビジネス&財務プレス

2026/02/19

ビジネス&財務プレス

2026/02/17

- 会社概要

- 私たちのストーリー

- イベント

- プレス

- 投資家向け情報

- 採用情報

- 品質

- 最新ニュース

ビジネス&財務プレス

2026/02/19

ビジネス&財務プレス

2026/02/19

ビジネス&財務プレス

2026/02/19

ビジネス&財務プレス

2026/02/17

We Power AI - グリッドからコアまで

人工知能(AI)アプリケーションの急速な進歩により、データセンターのエネルギー需要は大幅に増加しています。これにより、環境への責任を維持しながら、AIテクノロジーのスケーラビリティを向上させるという最重要課題が生じます。この記事では、この課題に対処するためのソリューションの概要について説明します。

2025/07/07

現代のテクノロジーにおけるAIの役割は変革的であり、基本的には半導体が提供する能力に依存しています。半導体はAIの中核をなすものです。AIシステムが機能するために必要な膨大な量のデータを強化、収集、処理、管理するのに役立ちます。これには、基本的な計算から、AIがデータから「学習」できるようにする複雑な機械学習タスクまで、あらゆるものが含まれます。

2010年以降、年間に生成されるデータ量は年々増加し、2ゼタバイトからスタートしています。2025年までに、データ量は175ゼタバイトに増加すると予想されており、これはわずか15年間で145倍以上に増加すると予想されています。

人工知能におけるデータの重要性は、いくら強調してもし過ぎることはありません。実際、人工知能、特に機械学習は、モデルのトレーニングに膨大な量のデータに大きく依存しており、ドキュメント、画像、温度や湿度などのセンサーの読み取り値など、さまざまな形式を網羅できます。このデータを分析することで、AIシステムはパターンと関係性を特定し、それを使用して予測、決定、出力の生成を行うことができます。AIシステムのトレーニングに使用されるデータの種類は、AIが開発されている特定のタスクと密接に関連しています。たとえば、大規模言語モデルなどのテキスト生成AIシステムは、効果的に機能するために大量のテキストデータを必要としますが、道路交通に関する予測分析は、正確な予測を行うためにセンサーデータに依存する場合があります。最終的に、AIシステムで使用されるデータの質と量は、その精度、信頼性、およびパフォーマンスに直接影響します。

データセンターは、AIのバックボーンとして重要な役割を果たしています。彼らは、これらの膨大なデータの流れを24時間処理しなければなりません。AI、特に生成AIは、このデータの増加を加速させ、増え続けるデータ需要には、シームレスな接続性、より高い帯域幅、広域カバレッジ、および多くの演算能力が必要であると私たちは考えています。

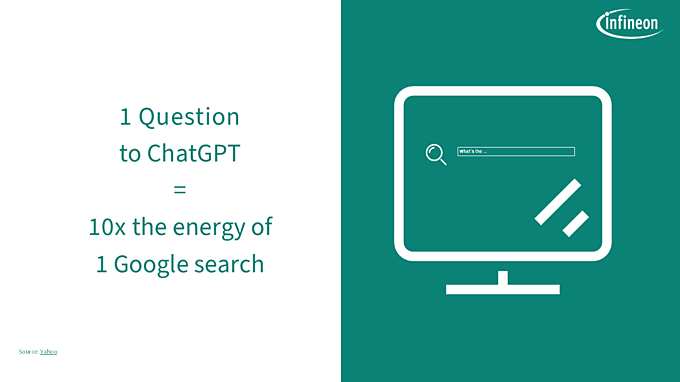

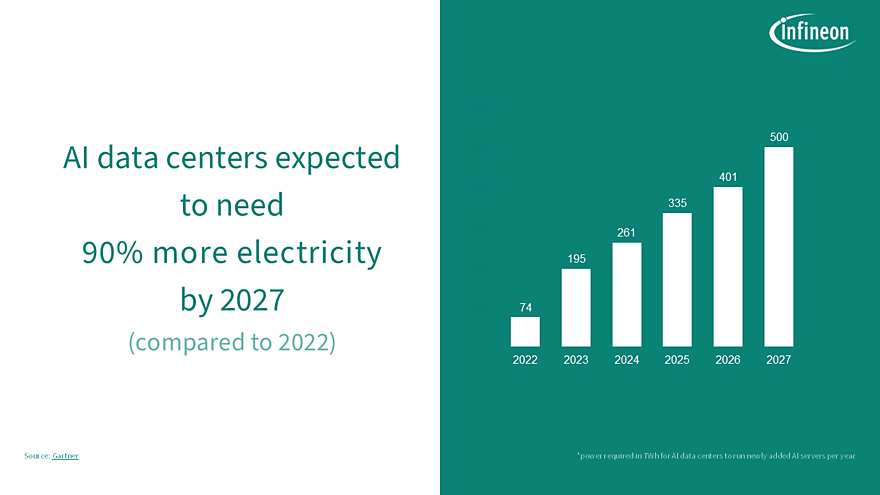

AIアプリケーションの急速な進歩により、データセンター内の電力需要は大幅に増加しています。AIモデルの学習や実行に電力が必要な理由は、機械学習アルゴリズムの複雑な計算に必要な演算能力にあります。最新のAIモデルの学習に必要な計算能力は、2012年以降、約3.4か月ごとに倍増しています。このコンピューティング要件の指数関数的な増加は、エネルギー要件の増加に直接反映され、ネットワークの全体的な負荷が増加します。計算が複雑になればなるほど、より多くのエネルギーが必要になります。これは、プロセッサ自体が消費する電力だけでなく、冷却システムや電源ネットワークなど、プロセッサをサポートするために必要なインフラにも関係します。

2025年4月に発表された最新の エネルギーとAIのレポートによると、リフト オフの軌跡では、データセンターとその必要なインフラからの世界の電力需要は2035年に1700 TWhを超えると見ています。2022年の~460 TWhは世界の電力需要の約2%に相当し、13年間で370%の増加となります。

簡単に言えば、電力の必要がないAIは存在しません。

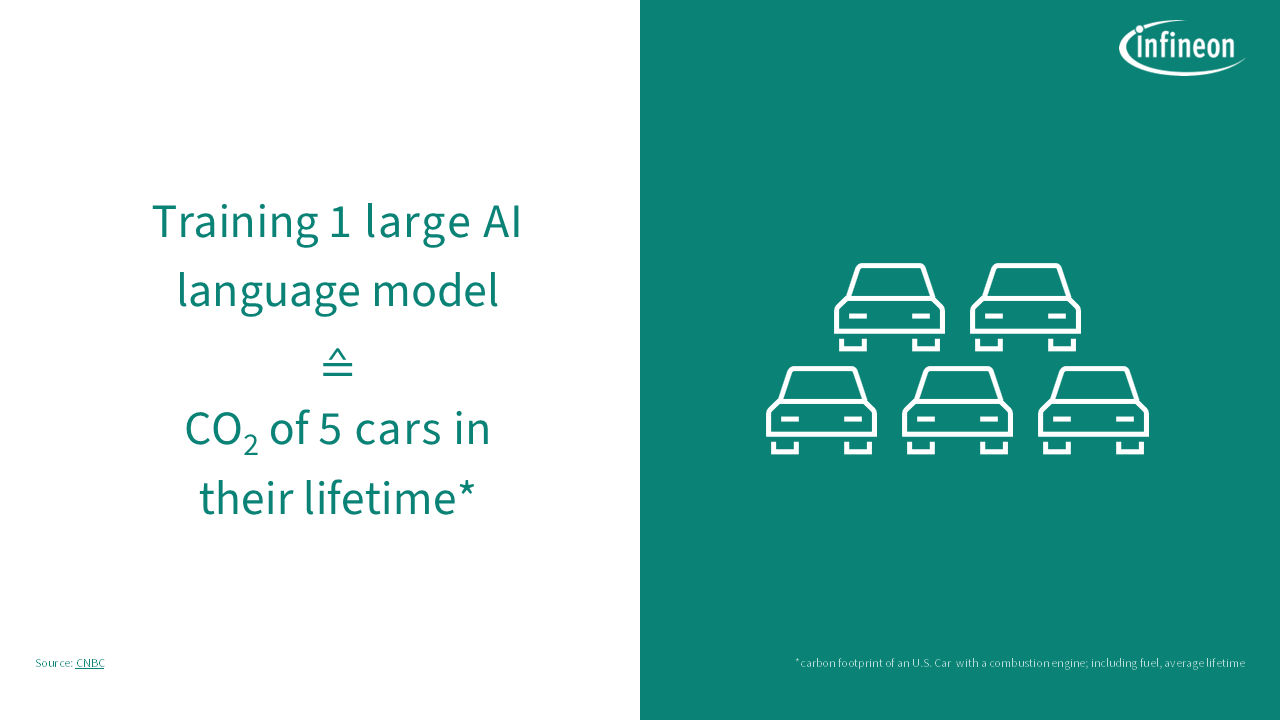

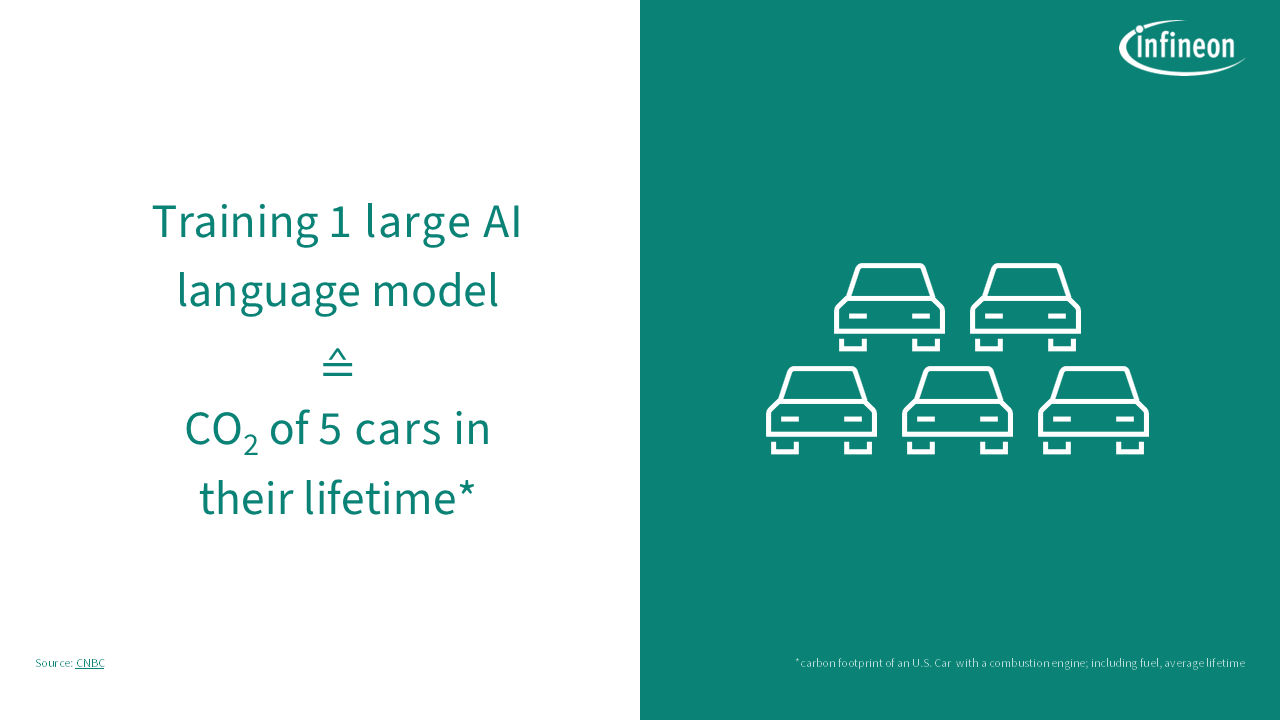

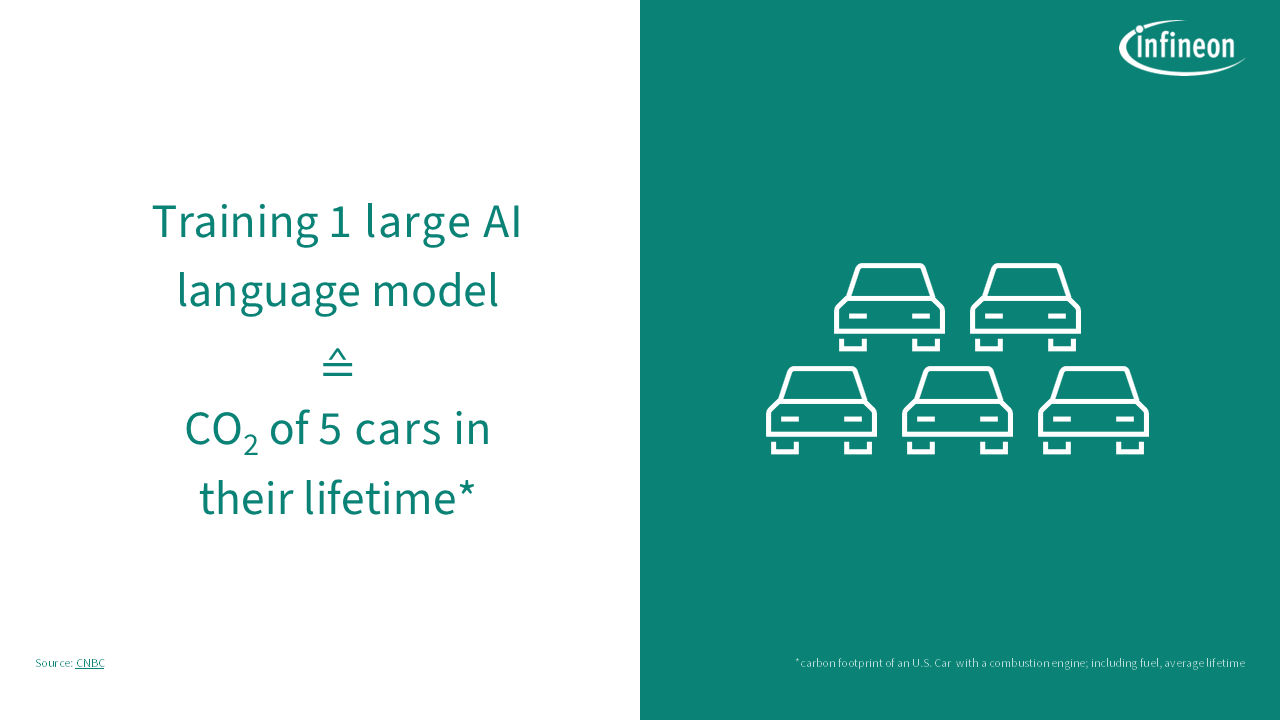

つまり、AIの素晴らしさの背後には、計算量と電力を大量に消費するプロセスがあり、その二酸化炭素排出量は膨大です。AIの機能を拡大する際には、AIデータセンターの大量のエネルギー消費を認識する必要がありますが、その多くは再生可能エネルギーではありません。さらに、AIデータセンターでは、過熱を防ぐために大規模な冷却メカニズムが必要であり、多くの場合、大量の水の使用量が発生します。これらの大規模なデータセンターを冷却するための水消費量は、小都市に匹敵する可能性があり、地域の水資源にさらなる圧力をかけています。

このような動きを考えると、エネルギー効率の向上に注力する必要があることがわかると思います。これは、たとえば、より効率的なAIアルゴリズムを開発したり、電力供給ネットワークの損失を大幅に削減する革新的でエネルギー効率の高い電力管理ソリューションを実装し、データセンターのインフラを最適化したりすることを意味します。これらの課題に対処することは、環境の持続可能性と、AIテクノロジーのスケールアップによる経済的な実行可能性を確保するために不可欠です。

この新しい課題には、多くの解決策があります。重要な点:ソリューションは、データセンターに入るグリッドからコアであるAIプロセッサへの電力変換効率をカバーする必要があります。

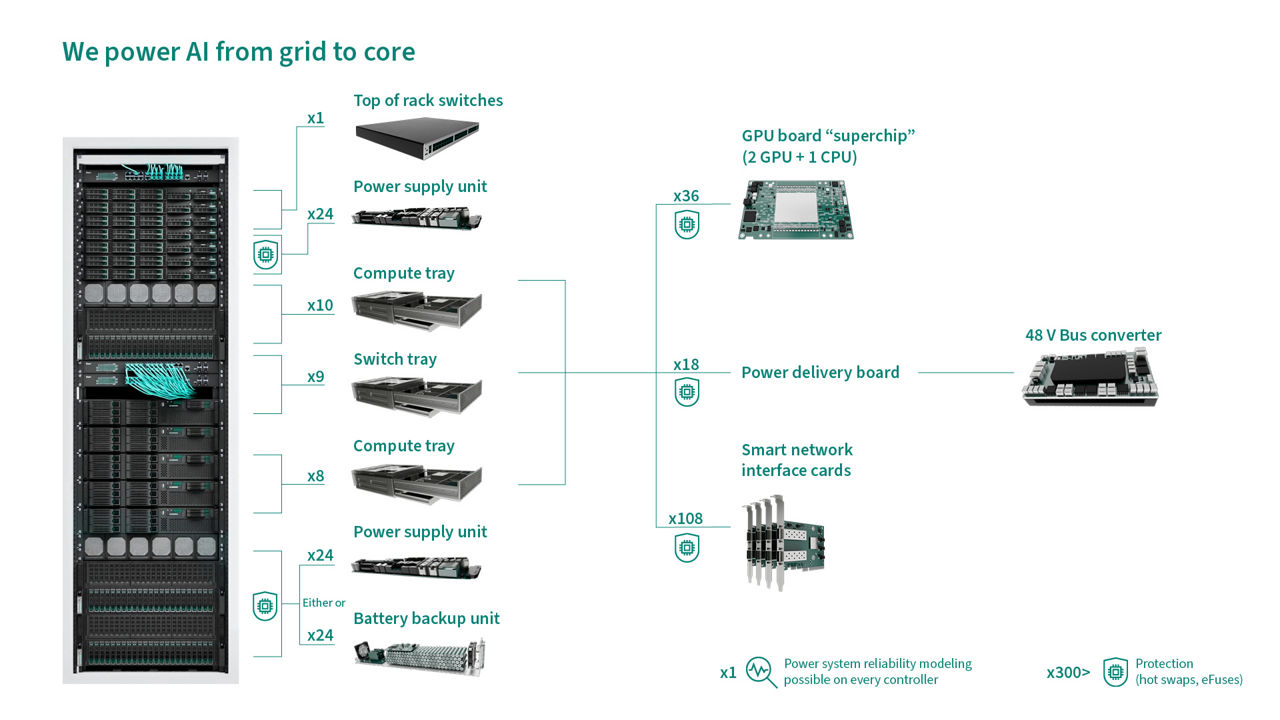

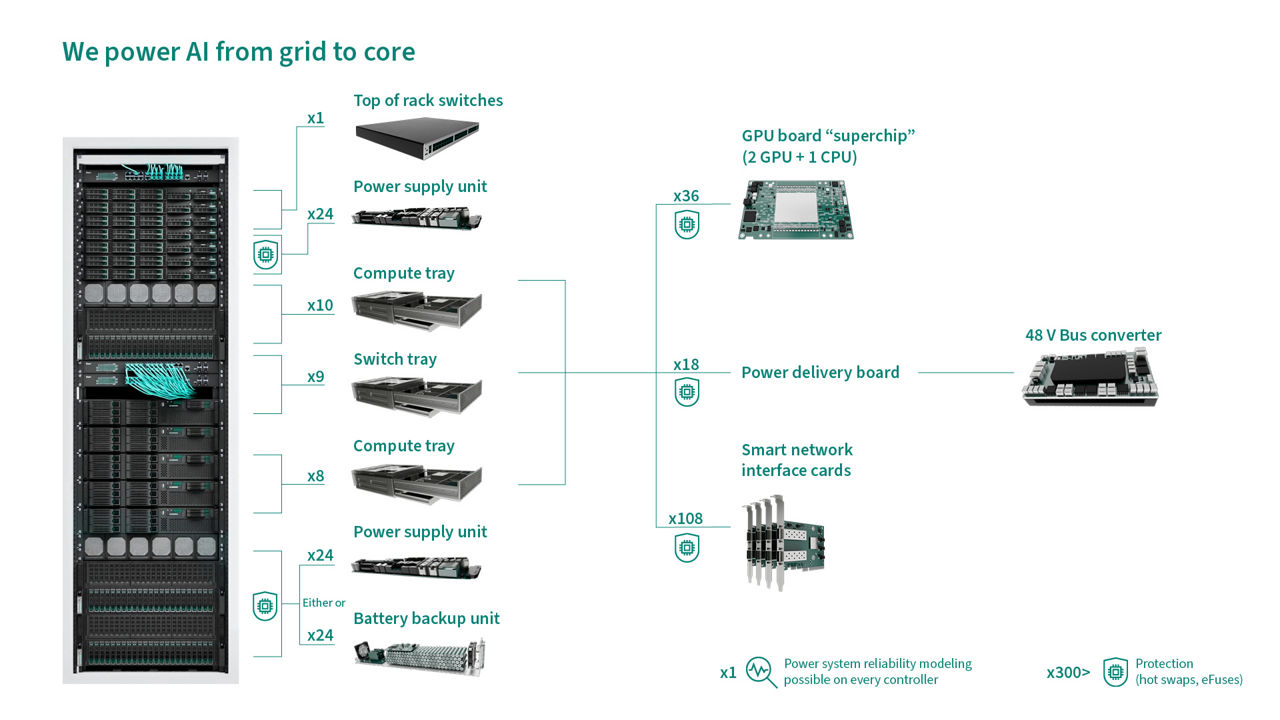

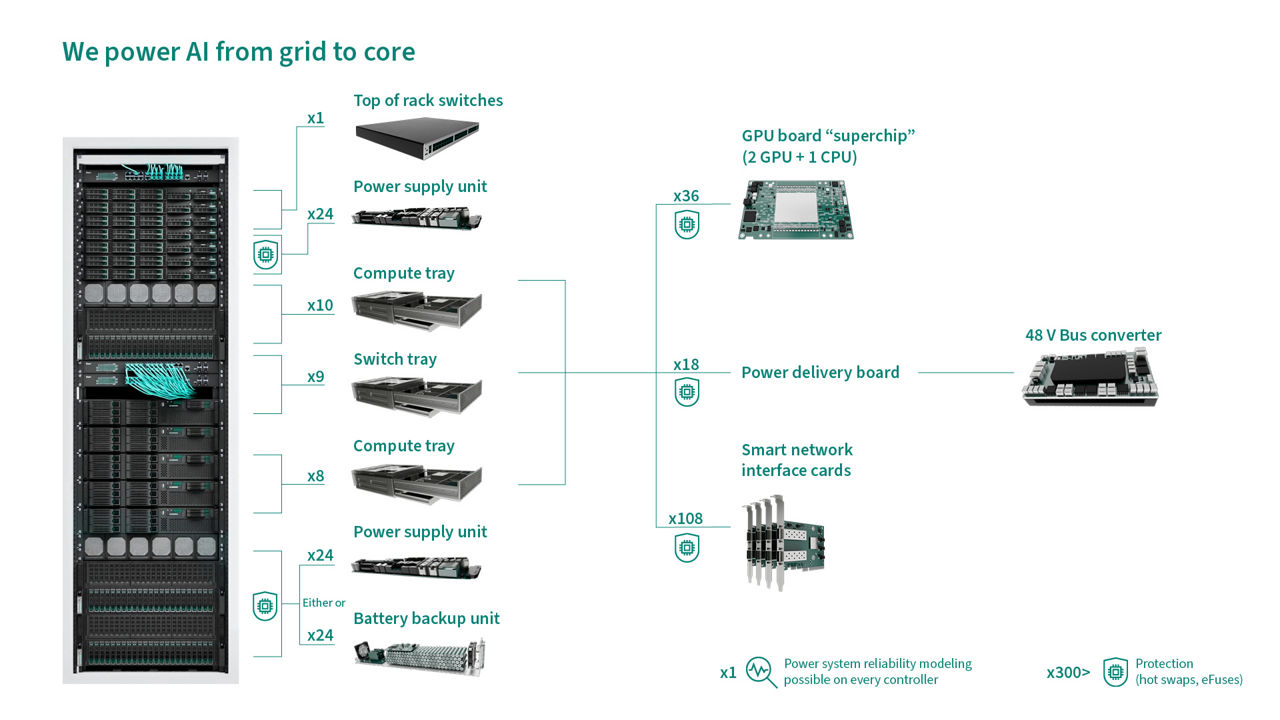

当社の革新的なパワー半導体ポートフォリオには、データセンターに入力するグリッドからそのコアであるAIプロセッサまでのソリューションが含まれ、Si、SiC、GaNの利点を活用して最高の効率、密度、堅牢性を実現します。このようなアプリケーションの例としては、トップオブザラックスイッチ、電源ユニット、バッテリー バックアップ ユニット(BBU)、DC-DCネットワーキングおよびコンピューティング(48 V中間バスコンバーター、電源モジュール、ディスクリート ソリューションなど)、保護などがあります。さらに、当社の新しい電力システム信頼性モデリングソリューションにより、データセンターは電源の信頼性と稼働時間を最大化し、動的なシステム パラメータロギングに基づくリアルタイムの電源ヘルスモニタリングを可能にします。

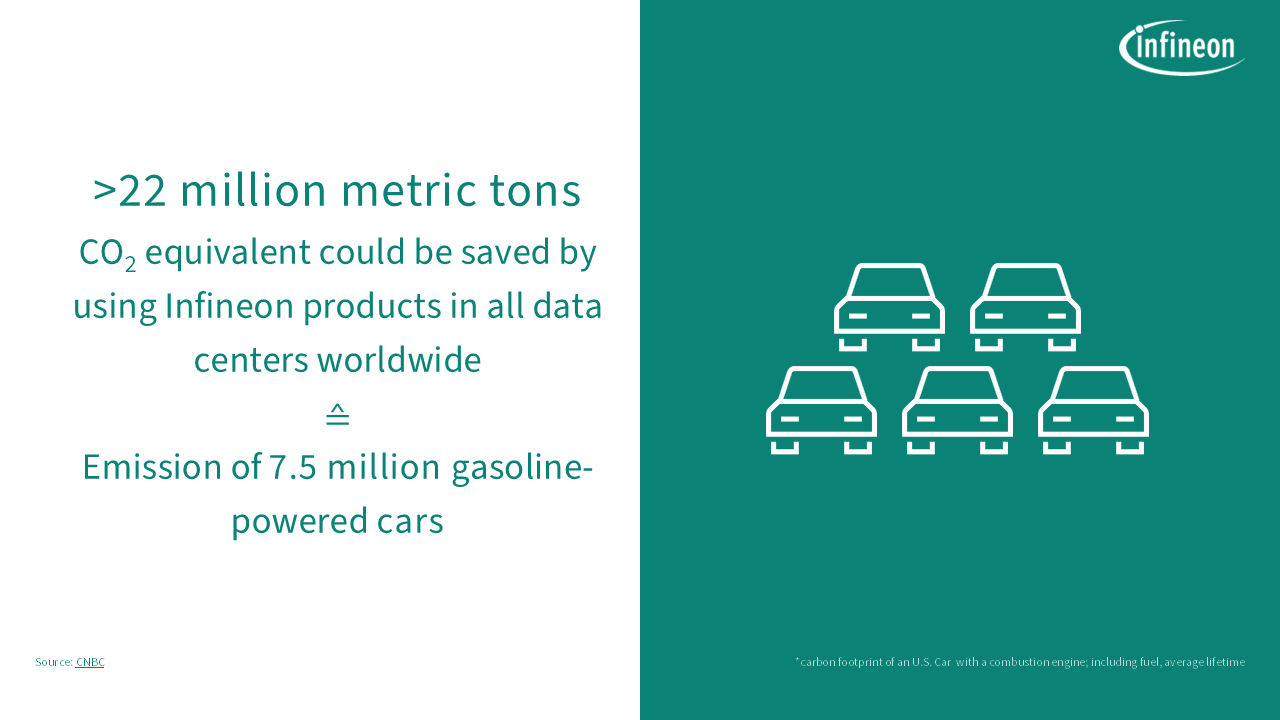

世界中で、これらの高度なパワー半導体により、約48 TWhのエネルギー節約を達成できます。これは、インフィニオンの分析によると、2,200万トン以上のCO₂ 排出量に相当します。

将来を見据えると、電力変換効率と性能を継続的に向上させながら、対処しなければならない多くの技術的課題が待ち受けています。私たちは、AIデータセンターにクリーンで信頼性の高いエネルギーをもたらすことを促進する必要があります。それは、私たちの環境責任と両立する方法でAIテクノロジーの持続可能な成長を可能にすることです。結局のところ、パワーのないAIは存在しません。この現実が、私たちをテクノロジーの進化に駆り立て、AIの進化に伴って、AIを効率的かつ効果的に推進するためのソリューションも進化するようにしています。