Infineon’s innovative XENSIV™ 60 GHz radar chip enables things to see and revolutionizes the Human Machine Interface

Since first promoting our breakthrough XENSIV™ 60 GHz radar chip back in 2016 at Google I/O, we have been jointly working with Google to make our bold vision a reality; in other words to revolutionize the Human Machine Interface of tomorrow. Google´s SoliTM project uses radar to enable new types of intuitive interactions. Have a look and see what radar is capable of:

Innovative technologies for touchless interaction – Infineon‘s XENSIV™ 60 GHz radar chip and Google´s software enable a new interface for your phone

Our innovative radar technology coupled with sophisticated software makes your presence and movements natural interfaces to your devices. Experience the break-through in gesture sensing in Google‘s new Pixel 4 and enjoy a new era of touchless human-machine-interactions.

Our XENSIVTM 60 GHz radar chip is one of the secrets behind our intuitive sensing capabilities. This 60 GHz radar sensor was first presented during the Google Developer Conference (Google I/O) in 2016. Click here to watch the full video of the Google I/O.

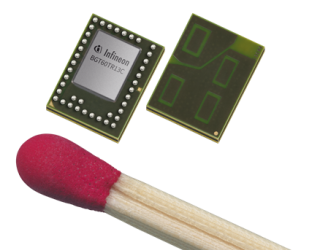

The Google SoliTM project builds on our radar know-how to enable new types of touchless human machine interactions – one where the human hand becomes a natural, intuitive interface for new devices and services. Our XENSIV™ 60GHz radar sensor can track sub-millimeter motion at high speed and accuracy. It fits onto a chip that can be produced at scale and can be used across a wide range of mobile, wearable and stationary devices.

Infineon brings its latest technology in the smallest form factor ever to the table

Find out more about our radar portfolio and get started today

Radar enables many new use cases in your smart home

Imagine a smart home where your devices can sense you and act accordingly. Think about speakers that always know what room you’re in, lights that automatically turn on when you enter a room and turn off again when you leave. Devices that activate as you approach.

Infineon’s highly accurate radar-based presence detection solution enables all of this – and more! Our intuitive sensing products allow smart devices to detect whether someone is in the field of view and to intuitively interact with that person.

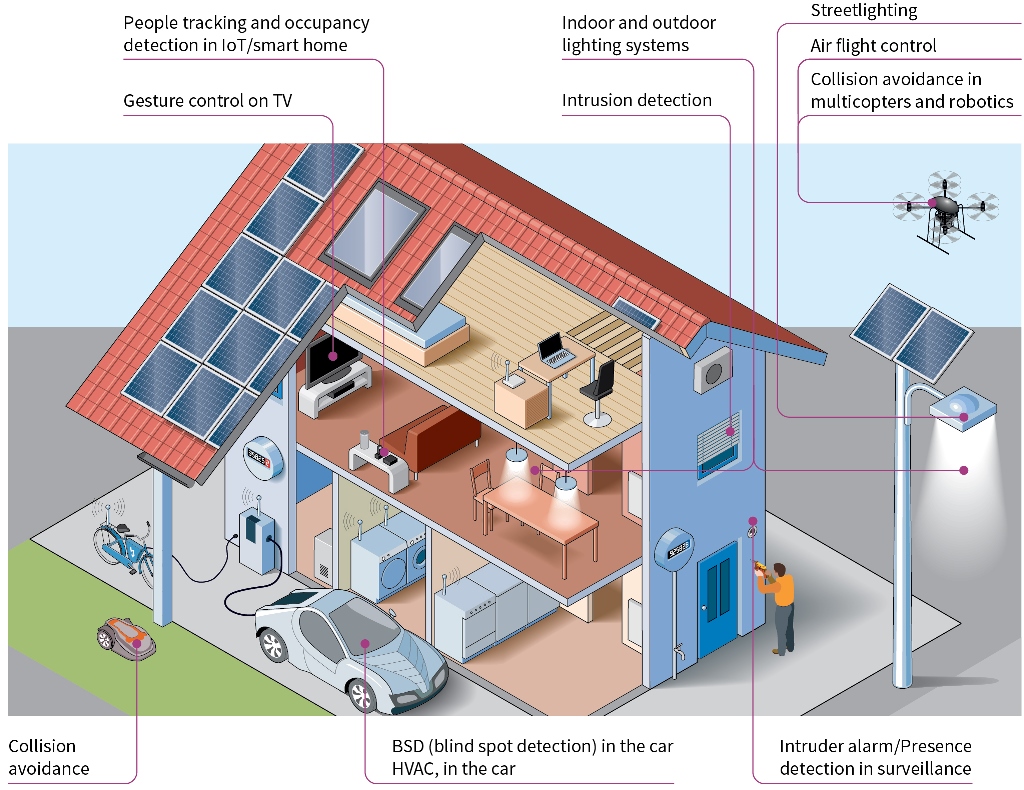

Radar is more than gestures. We enable new use cases for many applications

Radar is our secret weapon for many use cases. No matter if we talk about a smart home, a smart city, or mobility, radar will in future be a key technology. With radar for presence detection, for example, smart lighting is enabled with less power consumption than ever. In drones, radar technology enables distance measurement and thereby collision avoidance. In smart speakers audio quality can be improved significantly. You see, the possibilities are endless:

Applications

Intuitive sensing is more than radar

Besides our radar products, intuitive sensing is based on a wide range of different sensors that imitate our human senses. Radar and ToF enable your products to see, our pressure sensor portfolio enables devices to feel, the microphone to hear. Check out our product portfolio that will make your products even smarter.

Choose your type of sense:

Our idea of intuitive sensing – giving human senses to “things”

Imagine a world where technology is seamlessly integrated into our lives. Active communication between people and devices is no longer necessary. In this world, there is no need to push buttons or issue commands by directly addressing devices. Because technology is capable of implicitly interpreting context. This takes user experiences and human machine interaction to a whole new level, where it feels as though smart devices can intuitively understand what we want them to do.

Infineon’s intuitive sensing solutions enable people to intuitively interact with devices in smart homes, with robots in smart factories, and even with drones anywhere you like.